Un robot est-il capable de définir ce qu’est la beauté humaine ? Un groupe de scientifiques russes a tenté de répondre à la question en organisant un concours de beauté où le jury était une intelligence artificielle. Youth Laboratories, organisation financée par la Russie et Hongkong, a récolté, sur la base du volontariat, près de 600 000 portraits d’hommes et de femmes de plus de cent pays.

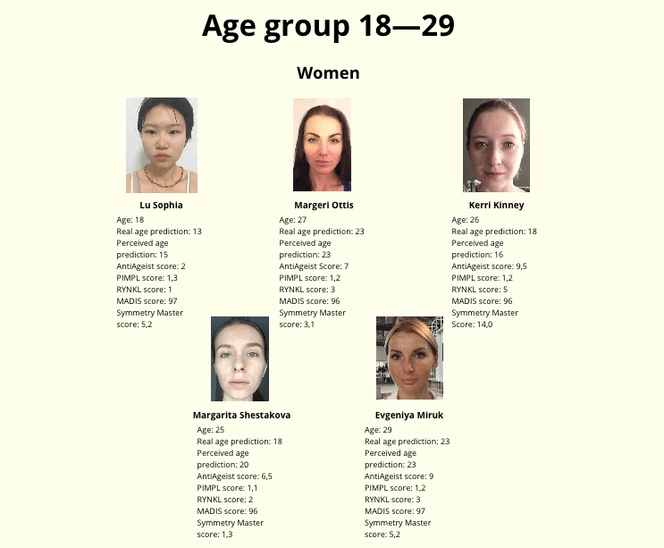

Trois algorithmes ont scanné cette base de données et sélectionné les « plus beaux » visages selon des critères les plus objectifs possible, comme la symétrie faciale, la présence ou non de rides, l’âge. Un des critères qui n’étaient pas pris en compte était la couleur de peau. Pourtant, lorsque les scientifiques ont découvert les 44 vainqueurs choisis par le jury-robot, ils ont découvert que 38 étaient blancs. Les six autres étaient asiatiques, dont un seul avait une peau relativement foncée.

Même si les trois quarts des participants à cette expérience étaient blancs, les résultats ont de quoi étonner. Théoriquement, l’intelligence artificielle, si elle n’est pas programmée pour prendre la couleur de peau comme un critère de beauté, devrait appliquer les critères choisis (symétrie, jeunesse) à toutes les photos, y compris celles de personnes à la peau foncée. Or, à voir les résultats, cela n’a pas été le cas.

« Deep learning » et algorithmes biaisés

Cela n’aurait aucun sens de dire que l’intelligence artificielle est « raciste ». Elle ne sait pas qu’elle regarde des photos d’êtres humains. Pour elle, il ne s’agit que de pixels. Pourquoi alors a-t-elle choisi très majoritairement des visages de personnes blanches ?

Konstantin Kiselev, directeur de la technologie au Youth Laboratories, pense que l’algorithme a été « possiblement biaisé » par la présence trop importante de candidats blancs. Sur les 600 000 candidats, environ 40 000 étaient indiens et 9 000 africains, et aucun n’a été considéré comme « beau » par l'’intelligence artificielle.

Celle-ci opère avec la technique du « deep learning », qui permet à un programme d’apprendre et de s’adapter en fonction des données qu’il a à sa disposition. En scannant les 600 000 images, le programme s’adapte et affine son idée de la « beauté ». Le programme fonctionne comme un « réseau de neurones », une machine virtuelle composée de milliers d’unités (les neurones) qui effectuent chacune de petits calculs simples.

Préjugés du monde réel dans l’intelligence virtuelle

Cette expérience rappelle, une fois de plus, que l’intelligence artificielle, de plus en plus présente dans maints aspects de nos vies, n’est pas neutre par définition. Elle dépend d’une multitude de facteurs humains, notamment des banques de données qui lui sont mises à disposition par ses créateurs. Il est faux et potentiellement dangereux de croire qu’une technologie dite « intelligente » sera objective par défaut.

« Ce sont les humains qui réfléchissent, même quand c’est présenté comme des algorithmes qui nous font croire que c’est neutre et scientifique », résume Bernard Harcourt, professeur de droit et de science politique à l’université Columbia.

Dans une tribune publiée en juin, Kate Crawford, chercheuse chez Microsoft ayant travaillé pour la Maison Blanche sur les questions d’intelligence artificielle, rappelle qu’il faut rester vigilant et sceptique face à ces technologies dites « intelligentes », qui risquent de répéter les préjugés du monde réels :

« Le sexisme, le racisme et d’autres formes de discrimination sont construites au sein même des algorithmes d’apprentissage automatique. Ces derniers sont au cœur des technologies qui donnent ces systèmes “intelligents”, qui nous catégorisent et décident de la façon dont on nous vend de la publicité en ligne […] Comme toutes les technologies qui l’ont précédée, l’intelligence artificielle reflétera les valeurs de ses créateurs. »

On a récemment eu un aperçu des dérapages possibles des programmes d’intelligence artificielle, dont certains ont pu avoir des conséquences bien plus graves que la sélection douteuse de photos dans un concours de beauté :

- Une enquête de ProPublica publiée en mai a montré qu’un programme informatique, dit de « maintien de l’ordre préventif » et utilisé par de nombreux départements de police américains, avait deux fois plus de chances de prédire, à tort, qu’un individu noir était un « élément à risque » et qu’un individu blanc était « un élément à faible risque ».

- Une étude scientifique de l’université Carnegie Mellon a prouvé que des publicités en ligne vantant des emplois avec un salaire annuel de 200 000 dollars apparaissaient bien plus souvent lorsque l’internaute était un homme.

- Un bot lancé en mars par Microsoft a produit des propos racistes, conspirationnistes et révisionnistes après huit heures d’existence. Il aura suffi qu’une poignée d’internautes lui posent sans cesse les mêmes questions (racistes, conspirationnistes et révisionnistes) pour que le programme d’intelligence artificielle les intègre de façon disproportionnée dans son fonctionnement. Comme l’expliquait Pixels à l’époque :

« Ses compétences (être capable de comprendre la demande de l’humain) mettent en lumière ses faiblesses (l’incapacité à saisir que le propos est problématique). »

Voir les contributions

Réutiliser ce contenu