Vous êtes ici

Trois mille ans d’informatique

Pierre Mounier-Kuhn, vous êtes chargé de recherche en histoire à la Sorbonne1 et au Centre Alexandre-Koyré2, et vous publiez avec Emmanuel Lazard, maître de conférences en informatique à l’université Paris-Dauphine, une Histoire illustrée de l’informatique(link is external). Comment replacez-vous la discipline informatique dans un cadre historique ?

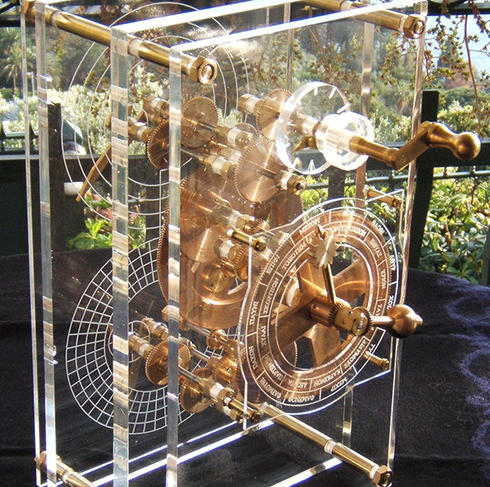

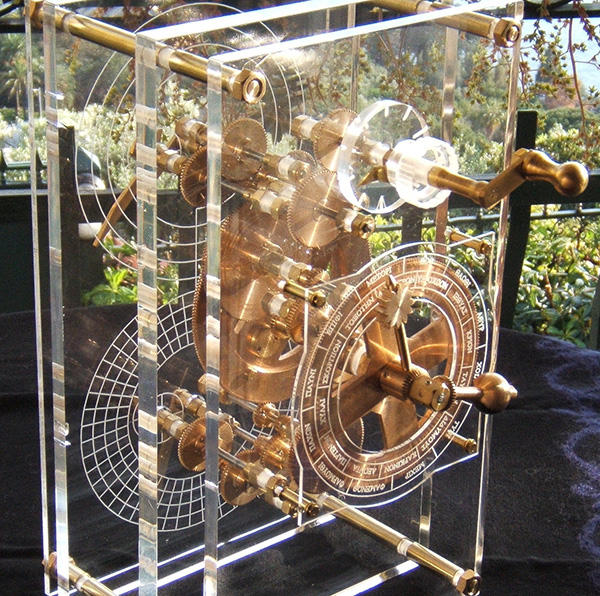

Pierre Mounier-Kuhn : Marginale jusqu’au milieu du XXe siècle, l’informatique est aujourd’hui devenue un phénomène historique massif : à la fois l’une des plus puissantes industries mondiales et une discipline scientifique bien établie. Notre ouvrage vise d’abord à partager la richesse de cette histoire, qui remonte à la machine d’Anticythère, voire aux premiers chiffres écrits à Sumer. L’histoire de l’informatique permet non seulement de comprendre ses origines et son développement, mais elle révèle aussi comment la société a réagi face à cette innovation. Mon premier travail de recherche portait d’ailleurs sur l’émergence de l’informatique au CNRS3.

Qu’est-ce qui a poussé les hommes à développer l’informatique ?

P. M.-K. : Trois besoins principaux : calculer, traiter des masses d’informations, automatiser des procédures. Dès le XVIIe siècle, entre Galilée et Newton, la mathématisation des sciences impose de plus en plus de calculs, motivant les machines de Schickard(link is external) et de Leibniz(link is external). Simultanément, Blaise Pascal conçoit sa calculatrice en 1642 pour aider son père, receveur des impôts dans l’administration royale. Ces demandes de la science, de l’État et des grandes organisations vont croître encore plus aux XIXe et XXe siècles. L’automation industrielle apparaît en 1801 avec les métiers à tisser Jacquard, où des cartes perforées servent de support aux « programmes » de confection des motifs. Ces cartes sont bientôt adaptées au calcul scientifique par Charles Babbage, ainsi qu’au traitement des données démographiques par Hermann Hollerith dans les années 1890, pour dépouiller le recensement américain. Dès le XIXe siècle, les techniques circulent donc entre ces trois grands domaines d’applications.

On parle parfois de machines de von Neumann et/ou de machines de Turing pour désigner les ordinateurs. Comment l’idée de l’ordinateur est-elle née ?

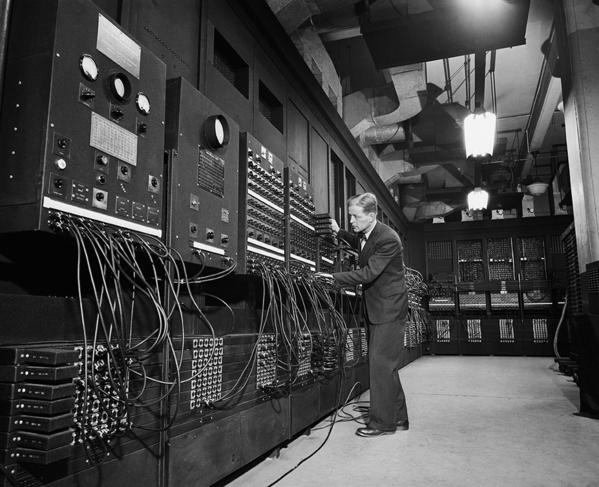

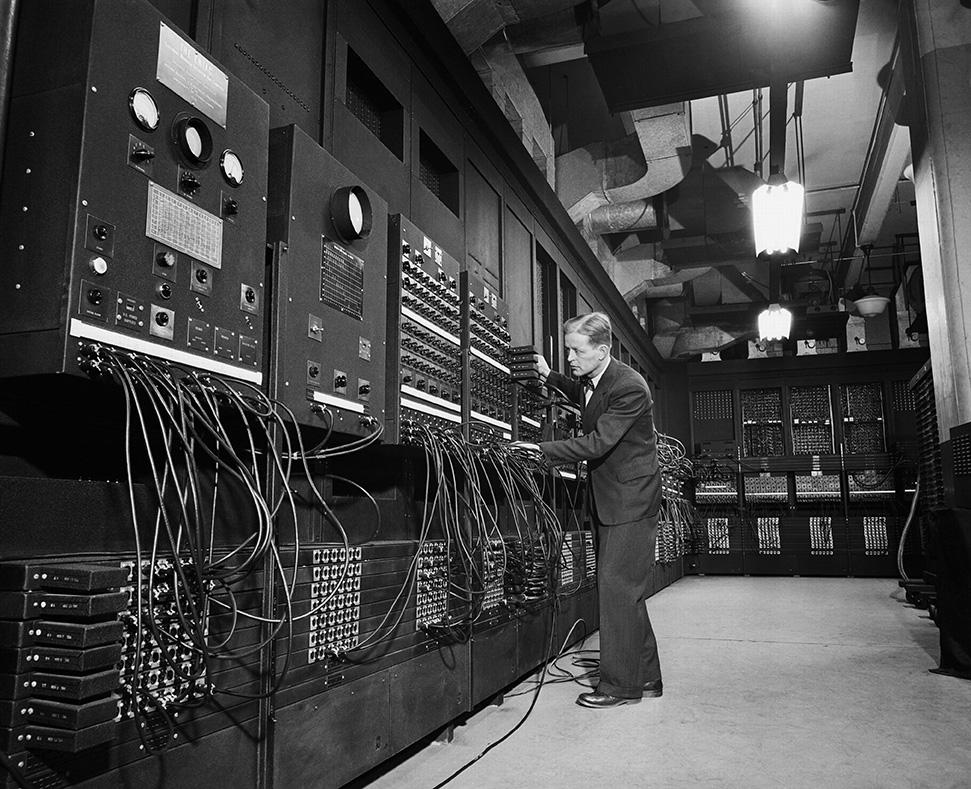

P. M.-K. : Une équipe de l’université de Pennsylvanie a conçu en 1943 l’énorme calculateur électronique Eniac4. Il calculait très vite, mais il fallait le reconfigurer en rebranchant les câbles pour chaque nouveau problème. D’où l’idée d’enregistrer le programme et les données sous forme électronique, directement accessible au processeur et facilement modifiable par l’opérateur. Cette idée a été formalisée en juin 1945 par John von Neumann, l’un des plus grands mathématiciens du XXe siècle. Son rapport décrit une future machine formée de quatre parties : processeur, unité de contrôle, mémoire et dispositifs d’entrée-sortie.

l’informatique

révèle aussi

comment la société

a réagi face à

cette innovation.

Si les technologies ont énormément évolué depuis, l’architecture de base est restée la même. Alan Turing, étudiant à Cambridge en 1936, cherchait à résoudre un problème de logique mathématique fondamentale. Pour sa démonstration, il a imaginé un dispositif calculant abstrait, nommé plus tard « machine de Turing », qui fournira un modèle théorique de l’ordinateur. Il joue ensuite un rôle décisif pendant la guerre en inventant des méthodes et des appareils qui permettront de décrypter les messages allemands. Fin 1945, il élaborera l’un des tout premiers projets d’ordinateurs en s’inspirant du rapport von Neumann.

Quel serait le premier « vrai » ordinateur, s’il est possible d’en choisir un ?

P. M.-K. : Tout dépend de la définition qu’on en donne ! L’Edsac5 fut le premier ordinateur à programme enregistré opérationnel, mis en service en 1949 à Cambridge sous la direction du mathématicien anglais Maurice Wilkes. L’Allemagne a aussi son héros fondateur : Konrad Zuse. Il a construit, dès la fin des années 1930, des calculateurs binaires programmables. Zuse a élaboré ensuite un système de programmation très avancé. La campagne récente de réhabilitation d’Alan Turing, condamné en 1952 pour délit d’homosexualité, permet paradoxalement à la Grande-Bretagne de rappeler qu’elle aussi a son « inventeur de l’ordinateur ». Ces distinctions attisent des controverses un brin nationalistes entre experts. Comme la France a raté le coche des premiers ordinateurs, les historiens français ont au moins la chance de ne pas participer à ces querelles de priorité !

À ce propos, comment le CNRS a-t-il géré l’apparition de l’informatique ?

P. M.-K. : Dès 1946, le CNRS a créé l’Institut Blaise-Pascal6 en fédérant un centre de calcul analogique et un laboratoire de calcul numérique. Mais ce dernier a été victime d’un calculateur électronique mal conçu et d’une mauvaise gestion de projet. Le CNRS a donné un nouveau départ à l'institut vers 1960 en changeant sa direction, en l’équipant de gros ordinateurs, puis en y fondant l’Institut de programmation avec la faculté des sciences de Paris, l’un des premiers départements d’informatique du monde ! Cet ensemble a lancé des recherches sur les applications non numériques des ordinateurs, comme la traduction ou la documentation automatique, en relation avec la linguistique computationnelle7 étudiée par Marcel-Paul Schützenberger et ses disciples. Particularité notable de cette époque, j’ai été très frappé d’y voir une forte présence féminine jusqu’aux années 1980. Plusieurs femmes ont dirigé des centres de calcul scientifique, avec de grandes responsabilités techniques et financières. En 1961, la première thèse de France en informatique a été soutenue par une assistante de l’université de Nancy, Marion Créhange. Ce phénomène oublié illustre les évolutions d’une discipline dont les normes et les codes sociaux peuvent changer plusieurs fois au cours d’une génération.

Comment s’est déroulée la popularisation de l’informatique ?

P. M.-K. : Certains industriels ont compris dès les années 1950 que l’ordinateur pourrait devenir un produit commercial à destination des laboratoires, de l’armée et des États. Le marché des ordinateurs de comptabilité et gestion a fini par dépasser celui du calcul scientifique en 1962. La baisse continue des coûts et les gains en performances ont favorisé la diffusion des mini-ordinateurs, puis des micro-ordinateurs dès les années 1970. L’intégration de ces machines à des réseaux numériques, particulièrement à l’Internet à partir des années 1990, a exercé un effet réseau multiplicateur : à partir du moment où l’on pense avoir intérêt à connecter ses instruments de travail et de loisir, on est poussé à utiliser davantage d’objets informatiques.

Quelle sera selon vous l’évolution de l’informatique ? La loi de Moore, selon laquelle la densité d’intégration des composants8 double tous les 18 mois à prix constant, va-t-elle rester vraie ?

P. M.-K. : Le problème des bugs et de la vérification de programmes reste crucial. Quant à la loi de Moore, j’entends depuis 35 ans qu’elle arrive au bout du rouleau. Elle est certainement proche de ses limites physiques, et ce problème se combine avec le défi de la dissipation thermique. L’alternative se trouvera-t-elle dans les ordinateurs quantiques ? Question à poser à nos collègues physiciens !

- 1. Centre Roland-Mousnier (CNRS/Univ. Paris-Sorbonne).

- 2. Unité CNRS/EHESS/MNHN.

- 3. L’Informatique en France de la Seconde Guerre mondiale au Plan Calcul. L’Émergence d’une science, P. Mounier-Kuhn, Pups, 2010.

- 4. Electronic Numerical Integrator and Computer, ou calculateur et intégrateur électronique numérique.

- 5. Electronic Delay Storage Automatic Computer, ou calculateur électronique automatique à mémoire à retard.

- 6. « Forteresse ou carrefour : l’Institut Blaise-Pascal et la naissance de l’informatique universitaire parisienne », Revue pour l’histoire du CNRS, A. Collinot et P. Mounier-Kuhn, automne-hiver 2011, n° 27-28.

- 7. Approche où les phénomènes linguistiques sont modélisés grâce aux mathématiques.

- 8. La densité d’intégration représente la quantité de composants électroniques pouvant être intégrés sur une surface donnée.

Auteur

Diplômé de l’École supérieure de journalisme de Lille, Martin Koppe a notamment travaillé pour les Dossiers d’archéologie, Science et Vie Junior et La Recherche, ainsi que pour le site Maxisciences.com. Il est également diplômé en histoire de l’art, en archéométrie et en épistémologie.

À lire / À voir

Histoire illustrée de l’informatique, Emmanuel Lazard et Pierre Mounier-Kuhn (préfacé par Gérard Berry), EDP Sciences, mars 2016, 36 €