Cet algorithme évalue votre babysitter en fouillant les réseaux sociaux

- - CC, Flickr (Fabio Rava)

En juillet dernier, Shyann Hills a été embauchée pour garder quatre enfants de 7 à 10 ans. Quelques jours plus tard, la jeune femme était arrêtée, accusée de torture et de maltraitance. Le cas est mis en avant par Predictim, une jeune entreprise californienne. Sur son site, la firme avance qu’elle aurait pu permettre d’éviter un tel drame. Pour 25 dollars (un peu plus de 20 euros), elle promet d’analyser un ou une candidate à la garde d’enfant sous toutes les coutures, en faisant le tour de ses publications sur les réseaux sociaux. Le tout en quelques secondes. Pour le moment, le service n’est disponible qu’aux Etats-Unis.

Pour les parents, l’opération est élémentaire: après avoir créé un compte et réglé la facture, ils n’ont qu’à renseigner le nom et l’adresse mail d’un ou d’une candidate. Bien que son consentement soit demandé avant d’entamer l’analyse, tout refus est notifié aux employeurs potentiels. Une fois ces étapes effectuées, les algorithmes de Predictim scannent le Web, à la recherche de toutes les publications Twitter, Facebook, Instagram - et autres - en lien avec le candidat ou la candidate.

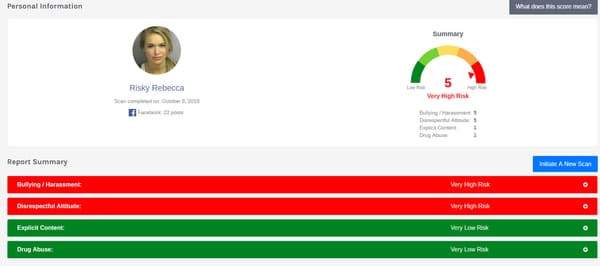

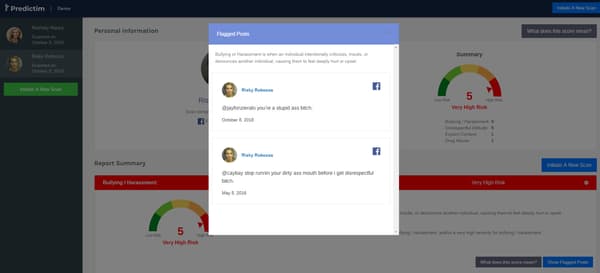

Un score allant de 1 à 5

Un rapport complet est ensuite rédigé de façon automatique, allouant un “score de risque” de 1 à 5. Il est lui-même décomposé en quatre notes, liées aux risques de harcèlement, de comportement irrespectueux, de publication de contenus explicites ou de consommation de drogues. Pour chacune de ces quatre catégories, Predictim met en lumière des publications jugées problématiques, identifiées sur les différents réseaux sociaux.

Pour plusieurs spécialistes, cette nouvelle manière de rassurer les parents apporte son lot de risques, à commencer par la multiplication des faux positifs. Il y a “une course à l’intelligence artificielle pour prendre toutes sortes de décisions, sans prendre la peine d’y apporter un regard humain”, regrette Jeff Chester, fondateur du Centre pour la démocratie numérique, l’une des principales organisations de protection des consommateurs aux Etats-Unis, auprès du Washington Post.

Des algorithmes opaques et imparfaits

“L’attractivité de ces technologies est probablement supérieure à leurs capacités réelles”, analyse Miranda Bogen auprès du média américain. D’après la membre d’Upturn, une organisation visant à surveiller l’utilisation des algorithmes dans les processus de sélection et de jugement, aucun outil n’est capable de mesurer l’efficacité réelle de services comme Predictim. Malgré ses promesses, l’entreprise se garde d’expliquer en détails le fonctionnement de son “intelligence artificielle”.

Pourtant, les failles et limites de ces programmes informatiques sont nombreuses, y compris chez les géants de la Silicon Valley. En octobre dernier, on apprenait qu’Amazon avait été contraint de mettre au placard son logiciel de tri des CV en raison de biais importants: en se basant sur l’historique des recrutements, l’algorithme avait pris l’habitude de privilégier les hommes. Malgré des tentatives d’amélioration, Amazon a finalement renoncé à l’utilisation de ce programme. Autant de biais d’âge, de sexe ou d’ethnie, qui pourraient concerner les algorithmes utilisés par Predictim.