L’algorithme de reconnaissance faciale, de l’entreprise française Idemia, est l’un des plus performants au monde. Pourtant, encore en 2019, il a du mal à distinguer les visages de femmes à la peau noire. C’est la conclusion d’une étude très solide du National Institute of Standards and Technology (NIST), publiée début juillet.

La reconnaissance faciale a fait des progrès phénoménaux ces dernières années. En novembre 2018, un rapport du même institut relevait qu’entre 2014 et 2018, ce type de logiciels « est devenu 20 fois meilleur pour chercher dans une base de données et trouver une photographie correspondante ».

Extrait d'un épisode dédié à la reconnaissance faciale dans la série d'anticipation Black Mirror.

Source : Netflix

Un taux d’erreurs 10 fois supérieur

Que ce soit aux États-Unis, en Australie, en France ou récemment à l’aéroport de Singapour, les algorithmes d’Idemia sont utilisés par la police pour venir en aide. Ce sont des millions de visages qui sont scannés par les technologies de l’entreprise et avec un excellent taux de réussite.

Mais cette efficacité a une importante limite, confirmée par le NIST lors d’un test de sensibilité. L’algorithme s’est trompé une fois sur 10 000 concernant les visages de femmes blanches, mais c’est à un taux d’une fois sur 1 000 qu’il a fait erreur pour les visages de femmes noires. La probabilité de réussite est donc 10 fois inférieure ou supérieure en fonction de la couleur de peau.

Donnie Scott, qui dirige la division américaine de sécurité publique chez Idemia, s’est défendu des conclusions du rapport en précisant à Wired que le code testé par le NIST est encore expérimental et que, de fait, il n’est pas commercialisé. « Il y a des différences physiques entre les gens et l’algorithme va s’améliorer à différentes vitesses pour ces différentes personnes », justifie Donnie Scott.

Les biais de la reconnaissance faciale

La constatation n’est pas nouvelle et vient confirmer un problème profond de la reconnaissance faciale. Les algorithmes ont notoirement plus de mal à reconnaître les peaux non blanches… ainsi que les femmes. « Les hommes blancs sont habituellement le segment démographique qui donne le taux le plus bas d’échec. Les femmes noires sont souvent le segment démographique qui donne le plus haut taux d’échec », indique le rapport.

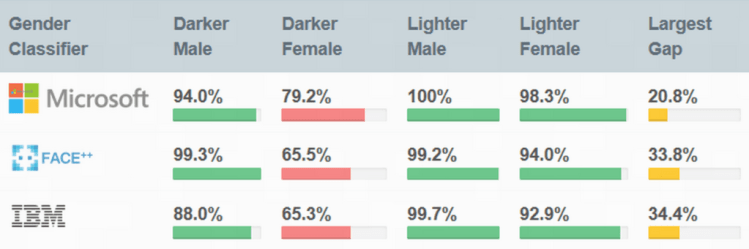

En 2018, le MIT Media Lab avait diffusé une grande enquête, sous forme de webdocumentaire, intitulé Gender Shades. À partir des algorithmes de Microsoft, IBM et Face++, elle pointait du doigt les biais de la reconnaissance faciale.

L'étude Gender Shades met en avant des différences importantes dans la reconnaissance faciale, basées sur le genre et la couleur de peau.

Source : Gender ShadesSi l’on prend, par exemple, l’algorithme de Microsoft, le taux de réussite est de 100 % pour les hommes à peau claire contre 79,2 % pour les femmes à peau noire. Les pourcentages démontrent des différences très marquées à la fois pour le genre et la couleur de peau.

Le rapport du NIST peut donc être corrélé avec d’autres études sérieuses qui l’ont précédé. Ce défaut intrinsèque n’empêche pas l’utilisation de la reconnaissance faciale dans la sphère publique, y compris pour le contrôle aux frontières.

Des disparités avant et après la conception

La présence d’une telle disparité dans des algorithmes pourtant très utilisés inquiète au regard des faux positifs : une reconnaissance faciale ratée a des chances d’associer par erreur le visage d’une personne innocente à celui d’une personne criminelle. L’organisation Big Brother Watch UK a ainsi relevé qu’en 2018 deux femmes innocentes ont été assimilées à deux hommes présents dans la base de données criminelle de la police.

Gender Bias concluait son enquête en affirmant qu’en réalité ces algorithmes sont utilisés avant même d’avoir été « publiquement testés pour une précision démographique ». La reconnaissance faciale s’appuie sur une intelligence artificielle et de la vision par informatique, entraînée par de l’apprentissage machine. Elle est entièrement dépendante des données primaires transmises lors de la programmation initiale. L’algorithme n’est pas neutre, il dépend de qui le conçoit et comment.

Raison pour laquelle la résolution du problème dépend des humains derrière l’IA : il faut des équipes qui soient moins homogènes, plus diversifiées démographiquement (en genres, en couleurs de peau…), afin que les variables démographiques soient ne serait-ce que pensées et prises en compte lors de la conception. « La diversité en IA aidera à réduire les biais », insiste le data scientist Maurizio Santamicone sur Towards Data Science en réagissant à l’étude du MIT.

Les auteurs de Gender Bias en appelaient eux-mêmes à une prise de conscience :« Nous risquons de perdre les bénéfices des droits civiques et des droits des femmes à force d’affirmer faussement que les machines sont neutres. Nous demandons plus de transparence et de responsabilité ». Au regard du dernier rapport du NIST, l’urgence est bel et bien là.

Nouveauté : Découvrez

La meilleure expérience de Numerama, sans publicité,

+ riche,

+ zen,

+ exclusive.

Si vous avez aimé cet article, vous aimerez les suivants : ne les manquez pas en vous abonnant à Numerama sur Google News.